Les modèles d’IA linguistique ont atteint une précision de 81 % dans la prévision des résultats de la recherche en neurosciences, dépassant largement le taux de réussite de 63 % des experts humains dans une étude unique en son genre qui souligne le potentiel de l’IA pour accélérer la découverte scientifique.

Publié dans Comportement humain | Temps de lecture estimé : 3 minutes

L’ampleur de la littérature scientifique moderne a créé un paradoxe : la richesse des recherches disponibles est devenue si écrasante que des idées cruciales passent souvent inaperçues. Aujourd’hui, des chercheurs de l’UCL ont démontré que l’intelligence artificielle peut aider à résoudre ce problème en identifiant des modèles dans des milliers d’études afin de prédire les résultats de la recherche avec plus de précision que les experts humains.

Dirigée par le Dr Ken Luo du département de psychologie et des sciences du langage de l’UCL, l’équipe de recherche a développé BrainBench, un outil permettant d’évaluer dans quelle mesure les grands modèles de langage (LLM) peuvent prévoir les résultats des neurosciences. Lorsqu’il a été testé auprès de 171 experts en neurosciences, chaque modèle d’IA a surpassé les spécialistes humains, même ceux possédant la plus grande expertise dans le domaine.

Le modèle spécialisé de l’équipe, BrainGPT, a atteint une précision encore plus impressionnante de 86 % après avoir été formé spécifiquement sur la littérature en neurosciences. Notamment, à l’instar des experts humains, les modèles d’IA ont montré une plus grande précision lorsqu’ils ont exprimé une plus grande confiance dans leurs prédictions.

« Les progrès scientifiques reposent souvent sur des essais et des erreurs, mais chaque expérience méticuleuse demande du temps et des ressources », explique le Dr Luo. « Même les chercheurs les plus compétents peuvent négliger les enseignements essentiels de la littérature. » Cette technologie pourrait aider les chercheurs à concevoir des expériences plus efficaces et à prendre des décisions plus éclairées quant à l’orientation de leurs recherches.

Le professeur Bradley Love, auteur principal de l’UCL, suggère que ces résultats révèlent quelque chose de plus profond sur la nature de la recherche scientifique : « Ce succès suggère qu’une grande partie de la science n’est pas vraiment nouvelle, mais se conforme aux modèles de résultats existants dans la littérature. Nous nous demandons si les scientifiques sont suffisamment innovants et exploratoires.

Glossaire

- Grands modèles de langage (LLM)

- Systèmes d’IA entraînés sur de grandes quantités de texte capables de traiter et de générer un langage semblable à celui d’un humain

- Banc de cerveau

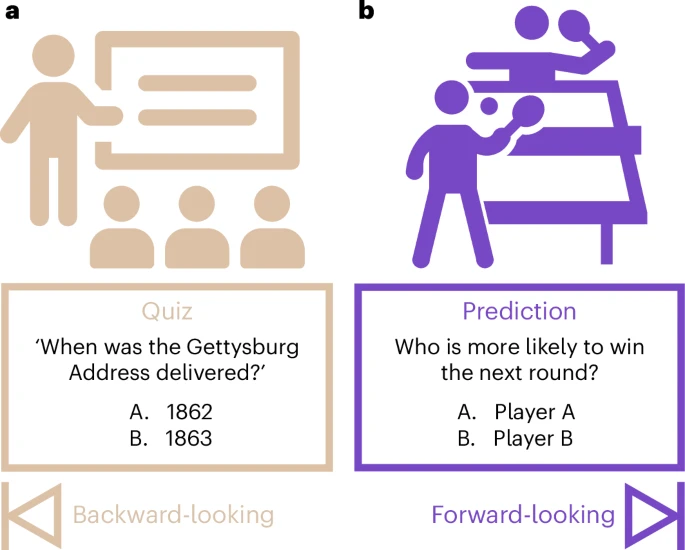

- Un outil de test qui compare les résultats réels d’études en neurosciences avec des alternatives plausibles mais incorrectes

- Score de perplexité

- Une mesure du degré de surprise ou d’inattendu d’un modèle d’IA qui trouve un morceau de texte particulier en fonction de son entraînement

Testez vos connaissances

Quel était le taux d’exactitude des modèles généraux d’IA dans la prévision des résultats de l’étude ?

Les modèles généraux d’IA ont atteint une précision de 81 %.

Dans quelle mesure les experts humains ont-ils été plus performants en considérant uniquement leur domaine d’expertise spécifique ?

Même dans leurs domaines spécifiques, les experts n’ont atteint qu’une précision de 66 %, ce qui reste bien en dessous des modèles d’IA.

Comment les performances du modèle spécialisé BrainGPT se comparent-elles à celles de sa version à usage général ?

BrainGPT a atteint une précision de 86 %, contre 83 % pour le Mistral à usage général, montrant une amélioration de 3 % grâce à une formation spécialisée.

Que suggère le succès de l’IA sur la recherche scientifique actuelle, selon le professeur Love ?

La grande précision des prévisions suggère qu’une grande partie de la recherche scientifique suit des modèles existants plutôt que d’être véritablement nouvelle, ce qui soulève la question de savoir si les scientifiques sont suffisamment innovants dans leur approche.

Informations complémentaires

Vous aimez cette histoire ? Abonnez-vous à notre newsletter sur scienceblog.substack.com.