L’année 2024 est l’une des plus grandes années électorales de l’histoire, avec des milliards de personnes aller aux urnes partout dans le monde. Même si les élections sont considérées comme protégées, affaires intérieures de l’État selon le droit international, les interférences électorales entre nations ont néanmoins augmenté. En particulier, opérations d’influence cybernétiques (CEIO) via les médias sociaux, y compris désinformation, désinformation ou « fausses nouvelles » – sont apparues comme une menace singulière que les États doivent contrer.

Les opérations d’influence ont d’abord pris une ampleur considérable auprès du public à la suite de Ingérence électorale russe dans l’élection présidentielle américaine de 2016. Ils n’ont pas diminué depuis. Des chercheurs, créateurs de politiques et sociétés de médias sociaux ont conçu diverses approches pour contrer ces CEOI. Cependant, cela nécessite en premier lieu de comprendre, souvent mal, le fonctionnement de ces opérations.

Bien entendu, l’information a été utilisée comme outil de gouvernance tout au long de l’histoire. Sun Tzu a proposé il y a plus de 2 000 ans que « l’art suprême de la guerre » consiste à «soumettre l’ennemi sans combattre.« À cette fin, l’information peut influencer, distraire ou convaincre un adversaire qu’il n’est pas dans son intérêt de se battre. Dans les années 1980, par exemple, l’Union soviétique a lancé Opération Infektion/Opération Denver visant à répandre le mensonge selon lequel le sida aurait été fabriqué aux États-Unis. Avec l’émergence du cyberespace, de telles opérations d’influence se sont étendues aux États-Unis. portée, échelle et rapidité.

Sur le soutien au journalisme scientifique

Si vous appréciez cet article, pensez à soutenir notre journalisme primé en s’abonner. En achetant un abonnement, vous contribuez à assurer l’avenir d’histoires percutantes sur les découvertes et les idées qui façonnent notre monde d’aujourd’hui.

Visions de cybergeddon-y compris cyberincidents catastrophiques ravageant les communications, le réseau électrique, l’approvisionnement en eau et d’autres infrastructures vitales, entraînant effondrement social-avoir capturé imaginaire public et a alimenté une grande partie du discours politique (y compris des références à un «Cyber-Pearl Harbor»).

Pourtant, les cyberopérations peuvent prendre une autre forme, ciblant les humains derrière les claviers plutôt que les machines via la manipulation de code. De telles activités menées dans le cyberespace peuvent viser à modifier la pensée et les perceptions d’un public, dans le but ultime de modifier son comportement. Organisation rassemblements politiques dans un état adversaire serait un exemple de mobilisation (changement de comportement). En tant que telles, les opérations d’influence cybernétiques modernes représentent la continuation de la concurrence internationale, sans conflit armé. Contrairement aux cyberopérations offensives susceptibles de pirater les systèmes en réseau, fermer un pipeline ou interrompre les communications, ils se concentrent sur le « piratage » de l’esprit humain. Cela s’avère particulièrement utile lorsqu’une puissance étrangère souhaite s’immiscer dans la politique intérieure d’un autre.

Les CEOI fonctionnent en établissant des boucles d’informations autonomes qui peuvent manipuler l’opinion publique et alimenter la polarisation. Ils sont « une nouvelle forme de « diviser pour régner » appliqué aux conditions géopolitiques de la concurrence plutôt qu’à la guerre« , ai-je récemment discuté avec un co-auteur du Renseignement et sécurité nationale journal.

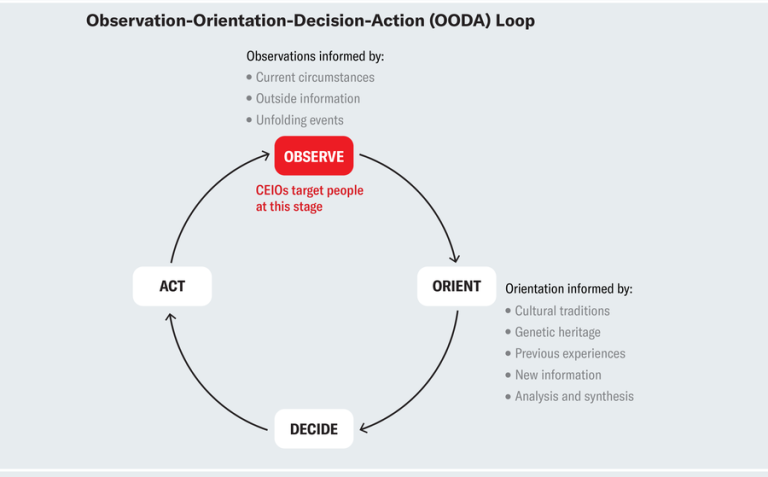

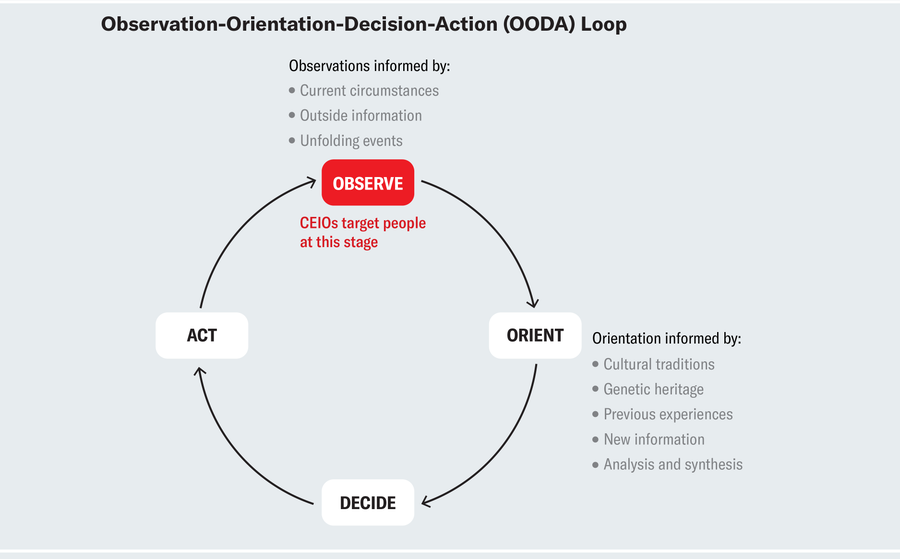

Mais comment se déroulent ces opérations ? Pour comprendre cela, nous pouvons utiliser le concept militaire de observation-orientation-décision-action (OODA), largement utilisée dans la stratégie et les tactiques de planification. Le modèle aide à expliquer comment les individus arrivent à prendre des décisions pertinentes pour la vie quotidienne : les individus dans une société (nous) prennent des informations de notre environnement (observation) et font en conséquence des choix stratégiques. Dans le cas d’un combat aérien (bataille aérienne à courte portée), le choix stratégique mènerait à la survie du pilote (et à la victoire militaire). Dans la vie de tous les jours, un choix stratégique pourrait consister à choisir le leader politique qui représenterait le mieux nos propres intérêts. Ici, changer ce qui est observé en injectant des informations supplémentaires dans la partie observation de la boucle OODA peut avoir des répercussions importantes. C’est précisément ce que visent les CEOI, en alimentant différentes parties du public avec des messages ciblés au stade de l’observation, visant à terme à modifier leurs actions.

Amanda Montañez ; Source : Un discours sur la victoire et la perte, par John R. Boyd ; Presse universitaire aérienne, 2018

Alors, comment les CEOI interrompent-ils la boucle OODA en utilisant les médias sociaux ? Les opérations d’influence cybernétiques fonctionnent selon des principes communs qui peuvent être compris à travers une identification-imitation-amplification cadre. Premièrement, les « étrangers » (acteurs malveillants) identifier cibler les publics et les questions controversées via les médias sociaux microciblage.

Suite à cela, les « étrangers » peuvent se faire passer pour des membres du public cible en usant de fausses identités, par le biais de imitation ce qui augmente leur crédibilité. Un exemple est le CEIO russe de 2016 sur Facebook, qui annonces achetées pour cibler le public américain, dirigé par les fameuses « usines à trolls » de Saint-Pétersbourg. Dans ces publicités, les trolls prenaient de fausses identités et a utilisé le langage qui suggérait qu’ils appartenaient à la société ciblée. Ils tentent ensuite d’exercer une influence grâce à des messages conçus pour trouver un écho auprès des publics cibles, favorisant un sentiment d’appartenance au groupe (au détriment de toute communauté présumée plus large, telle que la nation). Ces messages peuvent prendre la forme de désinformation traditionnelle, mais peuvent également utiliser informations factuellement correctes. Pour cette raison, l’utilisation du terme CEIO, au lieu de « désinformation », « désinformation » ou « fausses nouvelles », pourrait apporter une plus grande précision analytique.

Enfin, des messages personnalisés sont amplifié, tant dans le contenu (augmentation et diversification du nombre de messages) que par l’augmentation du nombre de groupes cibles. L’amplification peut également se produire via une publication multiplateforme.

Considérez un exemple: un message d’un soldat récemment enrôlé qui raconte son expérience vécue en voyant le 11 septembre à la télévision et dit que c’est cet événement qui l’a motivé à rejoindre l’armée. Il s’agit d’un message partagé par la page Facebook de Veterans Across the Nation. Le contenu de cet article peut être entièrement fabriqué et VAN peut ne pas exister « dans la vraie vie ». Cependant, une telle publication, bien que fictive, peut avoir l’impact émotionnel de l’authenticité, en particulier dans la manière dont elle est présentée visuellement sur une plateforme médiatique numérique. Et il peut être exploité à d’autres fins que la promotion d’un sentiment partagé de patriotisme, en fonction du contenu par lequel il est lié et amplifié.

Dans son CEOI utilisant Facebookle Russe Agence de recherche Internet ciblé divers publics nationaux aux États-Unis grâce à messagerie spécialement conçue visant à ingérence dans les élections de 2016comme le raconte le rapport Mueller.Il semblerait que 126 millions d’Américains aient été exposés aux efforts russes visant à influencer leurs opinions et leurs votes sur Facebook. Différents publics ont entendu des messages différents, les groupes étant identifiés à l’aide du microciblage de type menu de Facebook. caractéristiques. Les preuves montrent que la majorité des publicités achetées en Russie sur Facebook a ciblé les Afro-Américains avec des messages qui ne contenaient pas nécessairement de fausses informations, mais plutôt axés sur des sujets tels que la race, la justice et la police. Au-delà des États-Unis, La Russie aurait ciblé Allemagneaussi bien que ROYAUME-UNI

Pour prendre efficacement des décisions stratégiques, les individus doivent observer correctement leur environnement. Si la réalité observée est filtrée à travers une lentille manipulée de division, les points de désaccord social gérables (attendus dans les démocraties saines) peuvent être transformés en divisions potentiellement ingérables. Par exemple, l’accent populaire mis sur la polarisation aux États-Unis ignore la réalité selon laquelle la plupart des gens ne sont pas aussi polarisés politiquement qu’ils le pensent. La confiance dans les institutions peut être ébranlée, même sans l’aide des « fausses nouvelles ».

Comme le souligne le cadre d’identification-imitation-amplification, la question de savoir qui peut légitimement participer aux débats et chercher à influencer l’opinion publique est d’une importance cruciale et a une incidence sur la « réalité » observée. Lorsque la technologie permet à des étrangers (acteurs malveillants étrangers) de se faire passer de manière crédible pour des membres légitimes d’une certaine société, les risques potentiels de manipulation augmentent.

Avec environ 49 pour cent de la population mondiale participera aux élections en 2024, nous devons contrer les CEOI et l’ingérence électorale. Comprendre l’imitation, l’identification et l’amplification n’est que le point de départ. Les opérations d’influence étrangère utiliseront des informations véridiques pour influencer l’opinion publique. Nous devons réfléchir profondément à ce que cela signifie pour les affaires politiques intérieures. En outre, si le cyberespace offre un accès et un anonymat facilitant les opérations d’influence visant à influencer le public et à influencer les élections, les démocraties doivent effectivement limiter cet accès aux utilisateurs authentiques et légitimes tout en restant fidèles aux principes de liberté d’expression. Il s’agit d’une tâche difficile, que nous devons entreprendre de toute urgence.

Il s’agit d’un article d’opinion et d’analyse, et les opinions exprimées par l’auteur ou les auteurs ne sont pas nécessairement celles de Américain scientifique.